Vor einem dreiviertel Jahr haben Bernd Öggl, Sebastian Springer und ich das Buch Coding mit KI geschrieben und uns während dieser Zeit intensiv mit diversen KI-Tools und Ihrer Anwendung beschäftigt.

Was hat sich seither geändert? Wie sieht die berufliche Praxis mit KI-Tools heute aus? Im folgenden Fragebogen teilen wir drei unsere Erfahrungen, Wünsche und Ärgernisse. Sie sind herzlich eingeladen, in den Kommentaren eigene Anmerkungen hinzuzufügen.

Bei welchen Projekten hast du KI-Tools im letzten Monat eingesetzt? Mit welchem Erfolg?

Bernd: KI-Tools haben in meine tägliche Programmierung Einzug gehalten und sparen mir Zeit. Oft traue ich der Ki zu wenig zu und stelle Fragen, die nicht weit genug gehen. Zum „vibe-coding“ bin ich noch nicht gekommen :-) Ich verwende KI-Tools in diesen Projekten:

- ein großes Code Repo mit Angular und C#: Einsatz sowohl in VSCode (Angular) und Visual Studio (C#, die Unterstützung ist überraschend gut).

- ein kleines Projekt (HTML, JS, MongoDB (ca. 20.000 MongoDocs)).

- zwei verschiedene Flutter Apps für Android

- für eine größere PHP/MariaDB Codebase

Sebastian: Ich setze mittlerweile verschiedene KI-Tools flächendeckend in den Projekten ein. Wir haben das mittlerweile auch in unsere Verträge mit aufgenommen, dass das explizit erlaubt ist.

Die letzten Projekte waren in JavaScript/TypeScript im Frontend React, im Backend Node.js, und es waren immer mittelgroße Projekte mit 2 – 4 Personen über mehrere Monate.

Die verschiedenen Tools sind mittlerweile zum Standard geworden und ich möchte nicht mehr darauf verzichten müssen, gerade bei den langweiligen Routineaufgaben helfen sie enorm.

Michael: Ich habe zuletzt einige Swift/SwiftUI-Beispielprogramme entwickelt. Weil Swift und insbesondere SwiftUI ja noch sehr dynamisch in der Weiterentwicklung ist, hatten die KI-Tools die Tendenz, veraltete Programmiertechniken vorzuschlagen. Aber mit entsprechenden Prompts (use modern features, use async/await etc.) waren die Ergebnisse überwiegend gut (wenn auch nicht sehr gut).

Ansonsten habe ich in den letzten Monaten immer wieder kleinere Mengen Code in PHP/MySQL, Python und der bash geschrieben bzw. erweitert. Mein Problem ist zunehmend, dass ich beim ständigen Wechsel die Syntaxeigenheiten der diversen Sprachen durcheinanderbringe. KI-Tools sind da meine Rettung! Der Code ist in der Regel trivial. Mit einem sorgfältig formulierten Prompt funktioniert KI-generierter Code oft im ersten oder zweiten Versuch. Ich kann derartige Routine-Aufgaben mit KI-Unterstützung viel schneller erledigen als früher, und die KI-Leistungen sind diesbezüglich ausgezeichnet (besser als bei Swift).

Welches KI-Tool verwendest du bevorzugt? In welchem Setup?

Michael: Ich habe in den vergangenen Monaten fast ausschließlich Claude Pro verwendet (über die Weboberfläche). Was die Code-Qualität betrifft, bin ich damit sehr zufrieden und empfand diese oft besser als bei ChatGPT.

In VSCode läuft bei mir Cody (Free Tier). Ich verwende es nur für Vervollständigungen. Es ist OK.

Ansonsten habe ich zuletzt den Großteil meiner Arbeitszeit in Xcode verbracht. Xcode ist im Vergleich zu anderen IDEs noch in der KI-Steinzeit, die aktuell ausgelieferten KI-Werkzeuge in Xcode sind unbrauchbar. Eine Integration von Claude in Xcode hätte mir viel Hin und Her zwischen Xcode und dem Webbrowser erspart. (Es gibt ein Github-Copilot-Plugin für Xcode, das ich aber noch nicht getestet habe. Apple hat außerdem vor fast einem Jahr Swift Code angekündigt, das bessere KI-Funktionen verspricht. Leider ist davon nichts zu sehen. Apple = Gute Hardware, schlechte Software, zumindest aus Entwicklerperspektive.)

Für lokale Modelle habe ich aktuell leider keine geeignete Hardware.

Sebastian: Ich habe über längere Zeit verschiedene IDE-Plugins mit lokalen Modellen ausprobiert, nutze aber seit einigen Monaten nur noch GitHub Copilot. Die Qualität und Performance ist deutlich besser als die von lokalen Modellen.

Für Konzeption und Ideenfindung nutze ich ebenfalls größere kommerzielle Werkzeuge. Aktuell stehen die Gemini-Modelle bei mir ganz hoch im Kurs. Die haben mit Abstand den größten Kontext (1 – 2 Millionen Tokens) und die Ergebnisse sind mindestens genauso gut wie bei ChatGPT, Claude & Co.

Lokale Modelle nutze ich eher punktuell oder für die Integration in Applikationen. Gerade wenn es um Übersetzung, RAG und ähnliches geht, wo es entweder um Standardaufgaben oder um Teilaufgaben geht, wo man mit weiteren Tools wie Vektordatenbanken die Qualität steuern kann. Bei den lokalen Modellen hänge ich nach wie vor bei Llama3 wobei sich auch die Ergebnisse von DeepSeek sehen lassen können.

Für eine kleine Applikation habe ich auch europäische Modelle (eurollm und teuken) ausprobiert, wobei ich da nochmal deutlich mehr Zeit investieren muss.

Für die Ausführung lokaler Modelle habe ich auf die Verfügbarkeit der 50er-Serie von NVIDIA gewartet, wobei mir die RTX 5090 deutlich zu teuer ist. Ich habe seit Jahresbeginn ein neues MacBook Pro (M4 Max) das bei der Ausführung lokaler Modelle echt beeindruckend ist. Mittlerweile nutze ich das MacBook deutlich mehr als meinen Windows PC mit der alten 3070er.

Bernd: Ich verwende aus Interesse vor allem lokale Modelle, die auf meinem MacBook Pro (M2/64GB) wunderbar schnell performen (aktuell gemma3:27b und deepseek-r1:32b, aber das ändert sich schnell). Am MacBook laufen die über ollama. Ich muss aber beruflich auch unter Windows arbeiten und arbeite eigentlich (noch) am liebsten unter Linux mit neovim.

Dazu ist das Macbook jetzt immer online und im lokalen Netz erreichbar. Unter Windows verwenden ich in VSCode das Continue Plugin mit dem Zugriff auf die lokalen Modelle am MacBook. In Visual Studio läuft CoPilot (die „Gratis“-Version). Unter Linux verwende ich sehr oft neovim (mit lazyvim) mit dem avante-Plugin. Während ich früher AI nur für code-completion verwendet habe, ist es inzwischen oft so, dass ich Code-Blöcke markiere und der AI dazu Fragen stelle. Avante macht dann wunderbare Antworten mit Code-Blöcken, die ich wie einen git conflict einbauen kann. Sie sagen es ist so wie cursor.ai, aber das habe ich noch nicht verwendet.

Daneben habe ich unter Linux natürlich auch VSCode mit Continue. Und wenn ich gerade einmal nicht im Büro arbeite (also das Macbook nicht im aktuellen Netz erreichbar ist), so wie gerade eben, dann habe ich Credits für Anthropic und verwende Claude (3.5 Sonnet aktuell) für AI support.

Wo haben dich KI-Tools in letzter Zeit überrascht bzw. enttäuscht?

Sebastian: Ich bin nach wie vor enttäuscht wie viel Zeit es braucht, um den Kontext aufzubauen, damit dir ein LLM wirklich bei der Arbeit hilft. Gerade wenn es um neuere Themen wie aktuelle Frameworks geht. Allerdings lohnt es sich bei größeren Projekten, hier Zeit zu investieren. Ich habe in ein Test-Setup für eine Applikation gleich mehrere Tage investiert und konnte am Ende qualitativ gute Tests generieren, indem ich den Testcase mit einem Satz beschrieben habe und alles weitere aus Beispielen und Templates kam.

Ich bin sehr positiv überrascht vom Leistungssprung den Apple bei der Hardware hingelegt hat. Gerade das Ausführen mittelgroßer lokaler LLMs merkt man das extrem. Ein llama3.2-vision, qwq:32b oder teuken-7b funktionieren echt gut.

Bernd: Überrascht hat mich vor allem der Qualitäts-Gewinn bei lokalen Modellen. Im Vergleich zu vor einem Jahr sind da Welten dazwischen. Ich mache nicht ständig Vergleiche, aber was die aktuellen Kauf-Modelle liefern ist nicht mehr so ganz weit weg von gemma3 und vergleichbaren Modellen.

Michael: Ich musste vor ein paar Wochen eine kleine REST-API in Python realisieren. Datenbank und API-Design hab‘ ich selbst gemacht, aber das Coding hat nahezu zu 100 Prozent die KI erledigt (Claude). Ich habe mich nach KI-Beratung für das FastAPI-Framework entschieden, das ich vorher noch nie verwendet habe. Insgesamt ist die (einzige) Python-Datei knapp 400 Zeilen lang. Acht Requests mit den dazugehörigen Datenstrukturen, Absicherung durch ein Time-based-Token, komplette, automatisch generierte OpenAPI-Dokumentation, Wahnsinn! Und ich habe wirklich nur einzelne Zeilen geändert. (Andererseits: Ich wusste wirklich ganz exakt, was ich wollte, und ich habe viel Datenbank- und Python-Basiswissen. Das hilft natürlich schon.)

So richtig enttäuscht haben mich KI-Tools in letzter Zeit selten. In meinem beruflichen Kontext ergeben sich die größten Probleme bei ganz neuen Frameworks, zu denen die KI zu wenig Trainingsmaterial hat. Das ist aber erwartbar und insofern keine Überraschung. Es ist vielmehr eine Bestätigung, dass KI-Tools keineswegs von sich aus ‚intelligent‘ sind, sondern zuerst genug Trainingsmaterial zum Lernen brauchen.

Was wäre dein größter Wunsch an KI-Coding-Tools?

Bernd: Gute Frage. Aktuell nerven mich ein bisschen die verschiedenen Plugins und die Konfigurationen für unterschiedliche Editoren. Wie gesagt, neovim ist für mich wichtig, da hast du, wie in OpenSource üblich, 23 verschiedene Plugins zur Auswahl :-) Zum Glück gibt es ollama, weil da können alle anbinden. Ich glaub M$ versucht das eh mit CoPilot, eine Lösung, die überall funktioniert, nur ich will halt lokale Modelle und nicht Micro$oft….

Sebastian: Im Moment komme ich mit dem Wünschen ehrlich gesagt gar nicht hinterher, so rasant wie sich alles entwickelt. Microsoft hat GitHub Copilot den Agent Mode spendiert, TypeScript wird “mehr copiloty” und bekommt APIs die eine engere Einbindung von LLMs in den Codingprozess erlauben. Wenn das alles in einer ausreichenden Qualität kommt, hab ich erstmal keine weiteren Wünsche.

Michael: Ich bin wie gesagt ein starker Nutzer der webbasierten KI-Tools. Was ich dabei über alles schätze ist die Möglichkeit, mir die gesamte Konversation zu merken (als Bookmark oder indem ich den Link als Kommentar in den Code einbaue). Ich finde es enorm praktisch, wenn ich mir später noch einmal anschauen kann, was meine Prompts waren und welche Antworten das damalige KI-Modell geliefert hat.

Eine vergleichbare Funktion würde ich mir für IDE-integrierte KI-Tools wünschen. Eine KI-Konversation in VSCode mit GitHub Copilot oder einem anderen Tool sowie die nachfolgenden Code-Umbauten sind später nicht mehr reproduzierbar — aus meiner Sicht ein großer Nachteil.

Beeinflusst die lokale Ausführbarkeit von KI-Tools deinen geplanten bzw. zuletzt durchgeführten Hardware-Kauf?

Bernd: zu 100%! Mein MacBook Pro (gebraucht gekauft, M2 Max mit 64GB) wurde ausschließlch aus diesem Grund gekauft und es war ein großer Gewinn.

Ich habe jetzt ein 2.100 EUR Thinkpad und ein 2.200 EUR MacBook. Rate mal was ich öfter verwende :-) . Die Hardware beim Mac (besonders das Touchpad) ist besser und ich habe quasi alle Linux-Tools auch am Mac (fish-shell, neovim, git, Browser, alle anderen UI-Programme). Wenn ich unter Linux arbeite, denke ich mir oft: »Ah, das kann ich jetzt nicht ollama fragen, weil das nur am MacBook läuft«. Natürlich könnte ich Claude verwenden, aber irgend etwas im Kopf ist dann doch so: »Das muss man jetzt nicht über den großen Teich schicken.«

4000 EUR für die Nvidia-Maschine, die ich zusätzlich zum Laptop mitnehmen muss, ist kein Ding für mich. Ich möchte einen Linux Laptop, der die LLMs so schnell wie der Mac auswerten kann (und noch ein gutes Touchpad hat). Das ist der Wunsch ans Christkind …

Michael: Ein ärgerliches Thema! Ich bin bei Hardware eher sparsam. Vor einem Jahr habe ich mir ein Apple-Notebook (M3 Pro mit 36 GB RAM) gegönnt und damit gerade mein Swift-Buch aktualisiert. Leider waren mir zum Zeitpunkt des Kaufs die Hardware-Anforderungen für lokale LLMs zu wenig klar. Das Notebook ist großartig, aber es hat zu wenig RAM. Den Speicher brauche ich für Docker, virtuelle Maschinen, IDEs, Webbrowser etc. weitgehend selbst, da ist kein Platz mehr für große LLMs.

Aus meiner Sicht sind 64 GB RAM aktuell das Minimum für einen Entwickler-PC mit lokalen LLMs. Im Apple-Universum ist das sündhaft teuer. Im Intel/AMD-Lager gibt es wiederum kein einziges Notebook, das — was die Hardware betrifft — auch nur ansatzweise mit Apple mithalten kann. Meine Linux- und Windows-Rechner kann ich zwar billig mit mehr RAM ausstatten, aber die GPU-Leistung + Speicher-Bandbreite sind vollkommen unzureichend. Deprimierend.

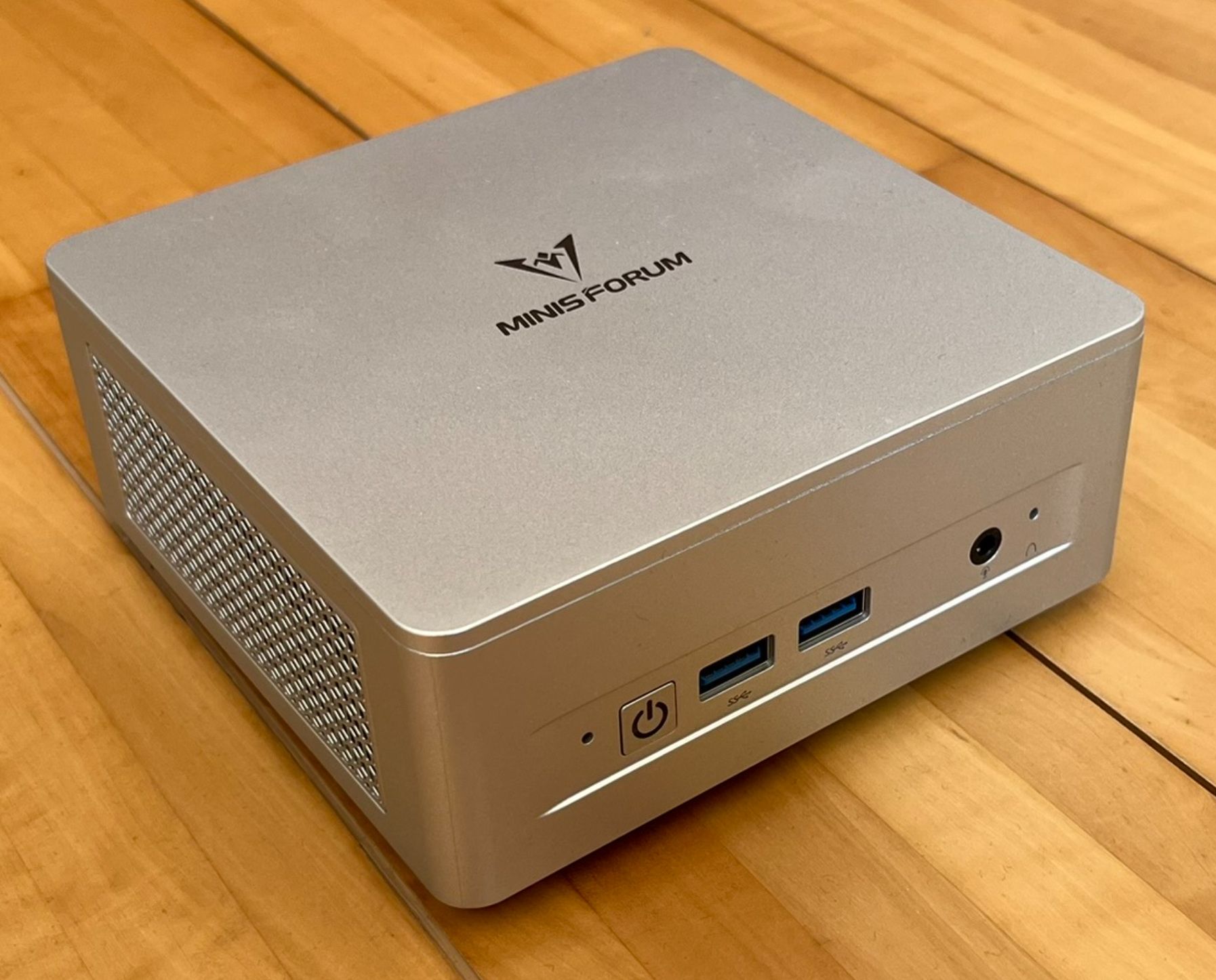

Ein externer Nvidia-Mini-PC (kein Notebook, siehe z.B. die diversen Ankündigungen auf notebookcheck.com) mit 128 GB RAM als LLM-Server wäre eine Verlockung, aber ich bin nicht bereit, dafür plus/minus 4000 EUR auszugeben. Da zahle ich lieber ca. 20 EUR/Monat für ein externes kommerzielles Tool. Aber derartige Rechner, wenn sie denn irgendwann lieferbar sind, wären sicher ein spannendes Angebot für Firmen, die einen lokalen LLM-Server einrichten möchten.

Generell bin ich überrascht, dass die LLM-Tauglichkeit bis jetzt kein großes Thema für Firmen-Rechner und -Notebooks zu sein scheint. Dass gerade Apple hier so gut performt, war ja vermutlich auch nicht so geplant, sondern hat sich mit den selbst entwickelten CPUs als eher zufälliger Nebeneffekt ergeben.

Sebastian: Ursprünglich war mein Plan auf die neuen NVIDIA-Karten zu warten. Nachdem ich aber im Moment eher auf kommerzielle Tools setze und sich mein neues MacBook zufällig als richtige KI-Maschine entpuppt, werde ich erstmal warten, wie sich die Preise entwickeln. Ich bin auch enttäuscht, dass NVIDIA den kleineren karten so wenig Speicher spendiert hat. Meine Hoffnung ist, dass nächstes Jahr die 5080 mit 24GB rauskommt, das wär dann genau meins.

Auf dem diesjährigen KDE-Entwicklertreffen im österreichischen Graz hat die KDE-Community weitreichende Entscheidungen für die Zukunft des Plasma-Desktops getroffen. Ziel ist es, Ressourcen effizienter einzusetzen, die Qualität weiter zu steigern und den Desktop besser auf reale Nutzerbedürfnisse auszurichten. Kein eigenes Plasma-LTS mehr Eine der zentralen Änderungen betrifft die langfristige Unterstützung (LTS) von KDE Plasma. Bisher hatte […]

Auf dem diesjährigen KDE-Entwicklertreffen im österreichischen Graz hat die KDE-Community weitreichende Entscheidungen für die Zukunft des Plasma-Desktops getroffen. Ziel ist es, Ressourcen effizienter einzusetzen, die Qualität weiter zu steigern und den Desktop besser auf reale Nutzerbedürfnisse auszurichten. Kein eigenes Plasma-LTS mehr Eine der zentralen Änderungen betrifft die langfristige Unterstützung (LTS) von KDE Plasma. Bisher hatte […] Im Linux CoffeeTalk im April werfen wir wie gewohnt einen Blick zurück auf alle wichtigen Themen des vergangenen Monats. Dich erwarten spannende Einblicke rund um Distributionen, Desktop-Umgebungen und Open Source Software im Allgemeinen. Also: Kaffee oder Tee schnappen, zurücklehnen und entspannt durch die Highlights des Monats gleiten! Viel Spaß beim Reinschauen oder Reinhören!

Im Linux CoffeeTalk im April werfen wir wie gewohnt einen Blick zurück auf alle wichtigen Themen des vergangenen Monats. Dich erwarten spannende Einblicke rund um Distributionen, Desktop-Umgebungen und Open Source Software im Allgemeinen. Also: Kaffee oder Tee schnappen, zurücklehnen und entspannt durch die Highlights des Monats gleiten! Viel Spaß beim Reinschauen oder Reinhören! Die Entwickler von openSUSE haben die Beta der mit Spannung erwarteten Leap 16.0 Version veröffentlicht. Die neue Linux-Distribution basiert erstmals vollständig auf SUSE Linux Enterprise 16 und dem neuen SUSE Linux Framework One, vormals bekannt als Adaptable Linux Platform (ALP). Mit Leap 16.0 schlägt das Projekt ein neues Kapitel auf. Das System setzt vollständig auf […]

Die Entwickler von openSUSE haben die Beta der mit Spannung erwarteten Leap 16.0 Version veröffentlicht. Die neue Linux-Distribution basiert erstmals vollständig auf SUSE Linux Enterprise 16 und dem neuen SUSE Linux Framework One, vormals bekannt als Adaptable Linux Platform (ALP). Mit Leap 16.0 schlägt das Projekt ein neues Kapitel auf. Das System setzt vollständig auf […] Am 31. Mai 2025 endet der reguläre Support für Ubuntu 20.04 LTS. Unternehmen, die weiterhin auf diese Version setzen, sollten dringend handeln. Mit Expanded Security Maintenance (ESM) erhalten Ubuntu Instnazen auch nach dem offiziellen Ende wichtige Sicherheitsupdates. So bleiben Server und Anwendungen zuverlässig geschützt. Doch reine Sicherheitsupdates decken nicht alle Risiken ab. Wenn ein Paket […]

Am 31. Mai 2025 endet der reguläre Support für Ubuntu 20.04 LTS. Unternehmen, die weiterhin auf diese Version setzen, sollten dringend handeln. Mit Expanded Security Maintenance (ESM) erhalten Ubuntu Instnazen auch nach dem offiziellen Ende wichtige Sicherheitsupdates. So bleiben Server und Anwendungen zuverlässig geschützt. Doch reine Sicherheitsupdates decken nicht alle Risiken ab. Wenn ein Paket […] Der US-Hersteller System76 hat COSMIC Alpha 7 veröffentlicht. Dabei handelt es sich um eine weitere Vorabversion des in Rust entwickelten Desktops für Linux, insbesondere für die firmeneigene Distribution Pop!_OS. Die neue Version bringt viele Verbesserungen rund um Arbeitsflächen. Diese lassen sich nun per Drag-and-Drop verschieben, neu anordnen oder auf andere Monitore ziehen. Zusätzlich gibt es eine […]

Der US-Hersteller System76 hat COSMIC Alpha 7 veröffentlicht. Dabei handelt es sich um eine weitere Vorabversion des in Rust entwickelten Desktops für Linux, insbesondere für die firmeneigene Distribution Pop!_OS. Die neue Version bringt viele Verbesserungen rund um Arbeitsflächen. Diese lassen sich nun per Drag-and-Drop verschieben, neu anordnen oder auf andere Monitore ziehen. Zusätzlich gibt es eine […] Das GNOME-Projekt hat Version 48.1 als erstes Wartungsupdate der neuen „Bengaluru“-Reihe veröffentlicht. Die Aktualisierung bringt zahlreiche Fehlerkorrekturen und Feinschliff für bestehende Funktionen mit sich. Mutter, der Fenstermanager von GNOME, erkennt nun Arbeitsplatzwechsel für Screenreader. Zudem wird HDR deaktiviert, wenn veraltete KMS-Treiber verwendet werden. Fällt ein HDR-Monitor aus, schaltet das System auf den Standardfarbmodus zurück. Mutter […]

Das GNOME-Projekt hat Version 48.1 als erstes Wartungsupdate der neuen „Bengaluru“-Reihe veröffentlicht. Die Aktualisierung bringt zahlreiche Fehlerkorrekturen und Feinschliff für bestehende Funktionen mit sich. Mutter, der Fenstermanager von GNOME, erkennt nun Arbeitsplatzwechsel für Screenreader. Zudem wird HDR deaktiviert, wenn veraltete KMS-Treiber verwendet werden. Fällt ein HDR-Monitor aus, schaltet das System auf den Standardfarbmodus zurück. Mutter […] .

. Oracle hat die achte Version seines hauseigenen Linux-Kernels vorgestellt. Der sogenannte Unbreakable Enterprise Kernel 8 (kurz UEK 8) basiert nun auf dem stabilen Linux-Kern 6.12 mit Langzeitunterstützung. Damit erhält Oracle Linux eine moderne und stark überarbeitete Kernel-Basis. Die neue Version bringt Verbesserungen bei Speicherverwaltung und I/O-Leistung. Zudem unterstützt sie aktuelle Technologien wie Intel SGX sowie […]

Oracle hat die achte Version seines hauseigenen Linux-Kernels vorgestellt. Der sogenannte Unbreakable Enterprise Kernel 8 (kurz UEK 8) basiert nun auf dem stabilen Linux-Kern 6.12 mit Langzeitunterstützung. Damit erhält Oracle Linux eine moderne und stark überarbeitete Kernel-Basis. Die neue Version bringt Verbesserungen bei Speicherverwaltung und I/O-Leistung. Zudem unterstützt sie aktuelle Technologien wie Intel SGX sowie […] Die Fedora-Community hat Version 42 der beliebten Linux-Distribution veröffentlicht. Wie gewohnt erscheint sie im Sechs-Monats-Rhythmus und bringt diesmal besonders viele Neuerungen mit. Mit an Bord: Linux-Kernel 6.14, ein überarbeiteter Installer und frische Desktop-Optionen. Eine der auffälligsten Änderungen betrifft den Installer: Die grafische Oberfläche Anaconda wurde komplett neu gedacht. Fedora setzt nun standardmäßig auf eine Web-Oberfläche […]

Die Fedora-Community hat Version 42 der beliebten Linux-Distribution veröffentlicht. Wie gewohnt erscheint sie im Sechs-Monats-Rhythmus und bringt diesmal besonders viele Neuerungen mit. Mit an Bord: Linux-Kernel 6.14, ein überarbeiteter Installer und frische Desktop-Optionen. Eine der auffälligsten Änderungen betrifft den Installer: Die grafische Oberfläche Anaconda wurde komplett neu gedacht. Fedora setzt nun standardmäßig auf eine Web-Oberfläche […]

Nach acht Jahren intensiver Arbeit an ArcoLinux beendet der Gründer Erik Dubois sein Engagement. Die Entscheidung sei nicht leichtgefallen, schreibt er in einer Abschiedsbotschaft. Doch mit fast 60 Jahren merke er, dass Energie und Konzentration nachlassen. Jetzt sei der richtige Moment, das Projekt in Würde zu übergeben. ArcoLinux war mehr als nur eine Linux-Distribution. Es […]

Nach acht Jahren intensiver Arbeit an ArcoLinux beendet der Gründer Erik Dubois sein Engagement. Die Entscheidung sei nicht leichtgefallen, schreibt er in einer Abschiedsbotschaft. Doch mit fast 60 Jahren merke er, dass Energie und Konzentration nachlassen. Jetzt sei der richtige Moment, das Projekt in Würde zu übergeben. ArcoLinux war mehr als nur eine Linux-Distribution. Es […]

Mit Apples Wechsel zu hauseigenen ARM-Prozessoren endete die X86-Ära auf Macs. Dadurch wurde es für alternative Systeme wie Linux deutlich schwieriger, Apple-Hardware zu unterstützen. Während frühere Intel-Macs problemlos mit Ubuntu & Co liefen, braucht es für Apple Silicon deutlich mehr Aufwand. Dennoch gelang es engagierten Entwicklern, Linux auf M1- und M2-Macs lauffähig zu machen. Selbst […]

Mit Apples Wechsel zu hauseigenen ARM-Prozessoren endete die X86-Ära auf Macs. Dadurch wurde es für alternative Systeme wie Linux deutlich schwieriger, Apple-Hardware zu unterstützen. Während frühere Intel-Macs problemlos mit Ubuntu & Co liefen, braucht es für Apple Silicon deutlich mehr Aufwand. Dennoch gelang es engagierten Entwicklern, Linux auf M1- und M2-Macs lauffähig zu machen. Selbst […] Das Linux-Mint-Team hat im März spannende Neuerungen für kommende Versionen angekündigt. Projektleiter Clement Lefebvre informierte in Rahmen des monatlichen Newsletters über den aktuellen Entwicklungsstand und neue Funktionen für Linux Mint und LMDE 7. Ein zentrales Thema ist die Einführung von OEM-Installationen für LMDE 7. Diese Funktion erlaubt es Linux Mint vorinstalliert auf Computern auszuliefern. Damit […]

Das Linux-Mint-Team hat im März spannende Neuerungen für kommende Versionen angekündigt. Projektleiter Clement Lefebvre informierte in Rahmen des monatlichen Newsletters über den aktuellen Entwicklungsstand und neue Funktionen für Linux Mint und LMDE 7. Ein zentrales Thema ist die Einführung von OEM-Installationen für LMDE 7. Diese Funktion erlaubt es Linux Mint vorinstalliert auf Computern auszuliefern. Damit […] Die Linux-Welt verzeichnet einen bedeutenden Schritt: Der beliebte Paketmanager APT geht in Version 3.0 an den Start. Die Veröffentlichung markiert den Beginn einer neuen stabilen Serie, gewidmet Steve Langasek, einem prägenden Mitgestalter von Debian und Ubuntu, der am 1. Januar 2025 verstarb. Mit dabei sind zahlreiche Verbesserungen: Übersetzungen in Sprachen wie Deutsch, Französisch, Katalanisch oder […]

Die Linux-Welt verzeichnet einen bedeutenden Schritt: Der beliebte Paketmanager APT geht in Version 3.0 an den Start. Die Veröffentlichung markiert den Beginn einer neuen stabilen Serie, gewidmet Steve Langasek, einem prägenden Mitgestalter von Debian und Ubuntu, der am 1. Januar 2025 verstarb. Mit dabei sind zahlreiche Verbesserungen: Übersetzungen in Sprachen wie Deutsch, Französisch, Katalanisch oder […] Der Paketmanager Zypper von openSUSE hat eine neue experimentelle Funktion erhalten. Künftig sind parallele Downloads möglich, ähnlich wie bei Pacman von Arch oder APT von Debian. Zudem wurde das Medien-Backend überarbeitet, um die Effizienz zu steigern. Diese Neuerungen wurden mit den Versionen libzypp 17.36.4 und Zypper 1.14.87 vorgestellt. Erste Benchmarks zeigen vielversprechende Ergebnisse denn die […]

Der Paketmanager Zypper von openSUSE hat eine neue experimentelle Funktion erhalten. Künftig sind parallele Downloads möglich, ähnlich wie bei Pacman von Arch oder APT von Debian. Zudem wurde das Medien-Backend überarbeitet, um die Effizienz zu steigern. Diese Neuerungen wurden mit den Versionen libzypp 17.36.4 und Zypper 1.14.87 vorgestellt. Erste Benchmarks zeigen vielversprechende Ergebnisse denn die […]